Claude Code 使用文档和中转站(长期更新)

先分享个我一直在用的机场,收费的,但稳定, 一般我买10块钱120G流量够用一年了 机场地址:https://xfltd.win/#/register?code=8wPC3qAb 如果需要干净点的梯子,用这个0.6刀/月,特别是针对google的gemini: 机场地址:https://mitce.

AI 开发工具使用技巧大全[20250720更新]

AI 开发工具使用技巧大全,全网唯一沉淀下来的精髓使用技巧,是我经过一年半时间,使用各类AI开发工具,做了很多产品后,沉淀下来的经验,非常据有实际指导意义,当然,有些技巧点,随着AI开发工具的迭代,本身也可能自动会带上了(比如最近推出的Kiro),万变不离其中,原则上都一样的。

终于有开发工具(Kiro)来实现项目规范管理了

介绍Vibe Coding 开发工具Kiro与市面上已有的AI开发工具不同之处,围绕需求文档、设计流程和任务拆解进行自动化组织。换句话说,它希望从一开始就把你的 prompt 引导进一个可以交付、可协作、可维护的开发流程,Kiro让氛围编码走出“造玩具”,开发流程结构化,解决Vibe Coding最后一公里问题。

![Augment Code无限续杯教程,持续更新,欢迎收藏[2025.10.29更新]](https://img.alicdn.com/imgextra/i4/36853727/O1CN01NIMOLe1dP1CNHx2q6_!!36853727.png)

Augment Code无限续杯教程,持续更新,欢迎收藏[2025.10.29更新]

Augment Code无限续杯方法,提供VS Code、JetBrains(含IDEA、PyCharm、Goland等全家桶)里面用的Augment Code破解方法,解决设备受限的问题(受限提示:Your account has been suspended because we believe you may be using multiple free trials. Please contact support here for more information.),同时提供使用cloudflare无限邮箱账号注册教程,本教程长期更新维护,欢迎收藏。

2025年AI编程工具全面对比:开发者必备指南

2025年AI编程工具全面对比指南:深入分析GitHub Copilot、通义灵码、Cursor、Augment等9款顶尖AI编程助手的功能、价格和适用场景。了解多模态支持、Agent模式、MCP集成等关键特性,助力开发者和团队选择最适合的AI编程工具,提升开发效率。无论您是企业开发团队还是独立开发者,本文将帮您在AI辅助编程时代做出明智选择。

一文看完大模型微调技术:微调背景、分类和微调全流程介绍

全网最全最完整的大模型微调系统性指导文章,包含微调背景、分类和微调全流程,内容涉及理论、技术原理、工具框架介绍,在微调过程中涉及数据准备、模型选择、环境准备、监控分析、超参数设置等等,充分结合各种场景,给于业务一定的判断和选择,是微调入门阅读的深度好文。

一文看懂什么是MCP(大模型上下文)?用来干什么的?怎么用它?

本文介绍下MCP的基本概念、功能价值、工作原理、能做什么以及怎么开发使用,文章最后附带一些相关的学习资料站,基本上学习MCP看这一文就足够了。

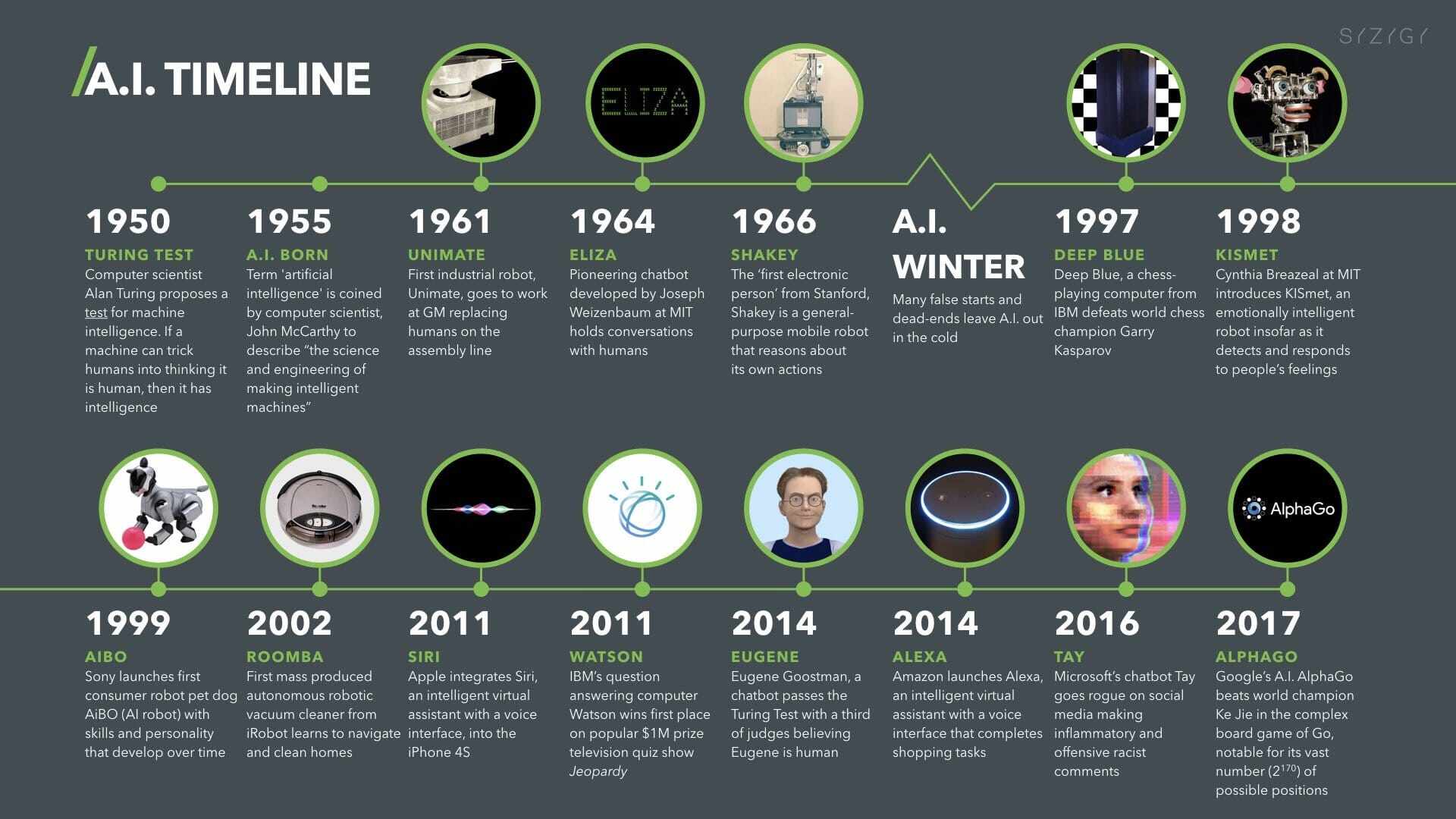

人工智能(AI)编年史 ,持续更新中...

全网最全的人工智能(AI)编年史,记录从1943年开始,至今发生的人工智能重要里程碑事件,往后也会持续更新!

OpenClaw 技术架构深度解析

本文深入剖析 OpenClaw(原名 Moltbot)的技术架构,涵盖基于 TypeScript 的 CLI 核心、Lane 任务队列、双重记忆系统及语义化浏览器快照等前沿 AI 技术细节。

10分钟通关瑞士万事达卡(Fiat24),≈0成本,从此绑卡不求人

1. 卡的用途 出入金,支付宝/微信消费,Apple/GooglePay,苹果/谷歌内购,GCP,wise…更多用途等待探索 另有帖子:记录一下Fiat万事达卡都能用来做什么 实测支付宝付款买了杯奶茶14.9(卡扣款2.1U,今日U价7.13,0损耗) 淘宝也可以消费,我U价比较低,好像还更便宜了…