人工智能(AI)编年史 ,持续更新中...

人工智能发展的主要历史事件记录,内容随时间不断更新,供AI行业人士参考。

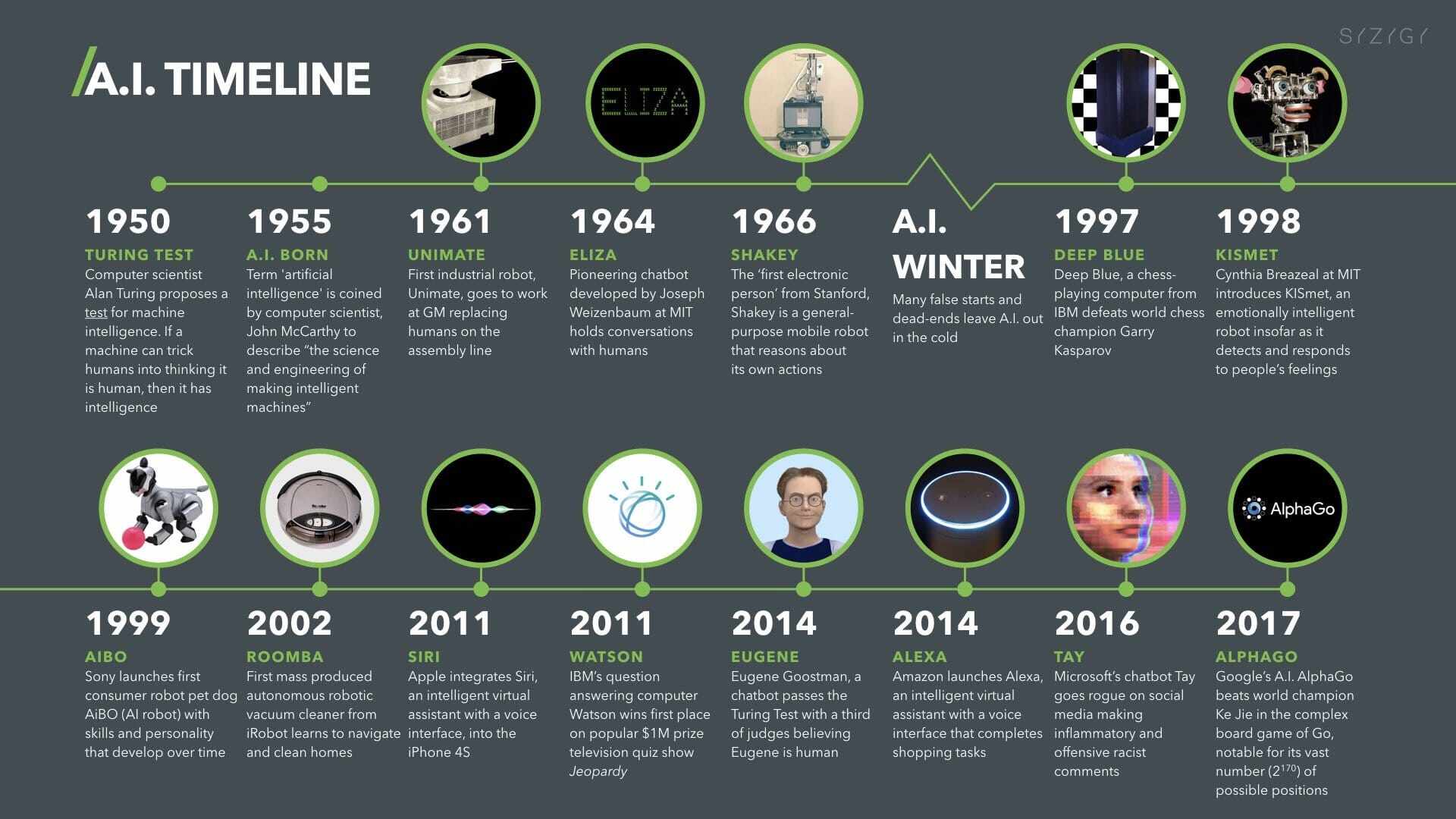

第一阶段:人工智能的诞生「1943 –1956」

1943年

图灵被称为计算机科学之父,也是人工智能科学之父。二战期间,他的团队在1943年研制成功了被叫做“巨人”的机器,用于破解德军的密码电报,这一贡献让二战提前2年结束,挽救了数千万人的生命

1946年

1946年,全球第一台通用计算机ENIAC诞生。它最初是为美军作战研制,每秒能完成5000次加法,400次乘法等运算。ENIAC为人工智能的研究提供了物质基础

1950年

1950年,一位名叫马文·明斯基(后被人称为“人工智能之父”)的大四学生与他的同学邓恩·埃德蒙,建造了世界上第一台神经网络计算机。这也被看做是人工智能的一个起点!

1950年,艾伦图灵提出“图灵测试”。如果电脑能在5分钟内回答由人类测试者提出的一些列问题,且其超过30%的回答让测试者误认为是人类所答,则通过测试。这边论文语言了创造出具有真正智能的机器的可能性。

1956年

1956年,计算机专家约翰·麦卡锡提出“人工智能”一词。这被人们看做是人工智能正式诞生的标志。麦卡锡与明斯基两人共同创建了世界上第一座人工智能实验室——MIT AI LAB实验室

第二阶段:人工智能黄金年代「1956 – 1974」

1958年

成立于1958年的国防高级研究计划署对人工智能领域进行了数百万的投资,让计算机科学家们自由的探索人工智能技术新领域!

约翰麦卡锡开发了LISP语言,成为以后几十年来人工智能领域最主要的编程语言!

1959年

1959年,首台工业机器人诞生。美国发明家乔治德沃尔与约瑟夫英格伯格发明了首台工业机器人,该机器人借助计算机读取示教存储程序和信息,发出指令控制一台多自由度的机械。它对外界环境没有感知

1959年,计算机游戏先驱亚瑟塞缪尔在IBM的首台商用计算机IBM 701上编写了西洋跳棋程序,这个程序顺利战胜了当时的西洋棋大师罗伯特尼赖。

1964年

1964年,首台聊天机器人诞生。美国麻省理工学院AI实验室的约瑟夫魏岑鲍姆教授开发了ELIZA聊天机器人,实现了计算机与人通过文本来交流。这是人工智能研究的一个重要方面。不过,它只是用符合语法的方式将问题复述一遍。

1965年

1965年,专家系统首次亮相。美国科学家爱德华费根鲍姆等研制出化学分析专家系统程序DENDRAL。它能够分析实验数据来判断未知化合物的分子结构。

1968年

1968年,首台人工智能机器人诞生。美国斯坦福研究所(SRI)研发的机器人Shakey,能够自主感知、分析环境、规划行为并执行任务,可以柑橘人的指令发现并抓取积木。这种机器人拥有类似人的感觉,如触觉、听觉等。

1970年

1970年,能够分析语义、理解语言的系统诞生。美国斯坦福大学计算机教授T·维诺格拉德开发的人机对话系统SHRDLU,能分析指令,比如理解语义、解释不明确的句子、并通过虚拟方块操作来完成任务。由于它能够正确理解语言,被视为人工智能研究的一次巨大成功。

第三阶段:人工智能第一次低谷「1974 – 1980」

1973年

1973年,著名数学拉特希尔家向英国政府提交了一份关于人工智能的研究报告,对当时的机器人技术、语言处理技术和图像识别技术进行了严厉的批评,尖锐的指出人工智能那些看上去宏伟的目标根本无法实现,研究已经完全失败。此后,科学界对人工智能进行了一轮深入的拷问,使AI的遭受到严厉的批评和对其实际价值的质疑。

1976年

1976年,专家系统广泛使用。美国斯坦福大学肖特里夫等人发布的医疗咨询系统MYCIN,可用于对传染性血液病患诊断。这一时期还陆续研制出了用于生产制造、财务会计、金融等个领域的专家系统

70年代末,人工智能进入低谷期。科研人员低估了人工智能的难度,美国国防高级研究计划署的合作计划失败,还让大家对人工智能的前景望而兴叹。主要技术瓶颈:计算机性能不足;处理复杂问题的能力不足;数据量严重缺失。

第四阶段:人工智能的繁荣期「1980 – 1987」

1980年

80年代,卡内基梅隆大学为数字设备公司设计了一套名为XCON的“专家系统”。它具有完整专业知识和经验的计算机智能系统。在1986年之前能为公司每年节省下来超过四千美元经费!

在80年代,一类名为“专家系统”的AI程序开始为全世界的公司所采纳,而“知识处理”成为了主流AI研究的焦点。日本政府在同一年代积极投资AI以促进其第五代计算机工程。80年代早期另一个令人振奋的事件是John Hopfield和David Rumelhart使联结主义重获新生。AI再一次获得了成功。

1981年

1981年,日本经济产业省拨款八亿五千万美元支持第五代计算机项目。其目标是造出能够与人对话,翻译语言,解释图像,并且像人一样推理的机器。令“芜杂派”不满的是,他们选用Prolog作为该项目的主要编程语言。

其他国家纷纷作出响应。英国开始了耗资三亿五千万英镑的Alvey工程。美国一个企业协会组织了MCC(Microelectronics and Computer Technology Corporation,微电子与计算机技术集团),向AI和信息技术的大规模项目提供资助。DARPA也行动起来,组织了战略计算促进会(Strategic Computing Initiative),其1988年向AI的投资是1984年的三倍。

1982年

1982年,物理学家John Hopfield证明一种新型的神经网络(现被称为“Hopfield网络”)能够用一种全新的方式学习和处理信息。大约在同时(早于Paul Werbos),David Rumelhart推广了“反传法(en:Backpropagation)”,一种神经网络训练方法。这些发现使1970年以来一直遭人遗弃的联结主义重获新生。

1984年

1984年,大百科全书(Cyc)项目。Cyc项目试图将人类拥有的所有一般性知识都输入计算机,建立一个巨型数据库,并在此基础上实现知识推理,它的目标是让人工智能的应用能够以类似人类推理的方式工作,成为人工智能领域的一个全新研发方向。

1986年

1986年由Rumelhart和心理学家James McClelland主编的两卷本论文集“分布式并行处理”问世,这一新领域从此得到了统一和促进。90年代神经网络获得了商业上的成功,它们被应用于光字符识别和语音识别软件。

1987年

1987年,苹果和IBM公司生产的台式机性超过了Symbolics等厂商生产的通用计算机。从此,专家系统风光不再。80年代末,美国国防先进研究项目局高层认为人工智能并不是“下一个浪潮”。

至此,人工智能再一次成为浩瀚太平洋中那一抹夕阳红

第五阶段:人工智能第二次低谷「1987 – 1993」

80年代中商业机构对AI的追捧与冷落符合经济泡沫的经典模式,泡沫的破裂也在政府机构和投资者对AI的观察之中。尽管遇到各种批评,这一领域仍在不断前进。来自机器人学这一相关研究领域的Rodney

Brooks和Hans Moravec提出了一种全新的人工智能方案

变天的最早征兆是1987年AI硬件市场需求的突然下跌。Apple和IBM生产的台式机性能不断提升,到1987年时其性能已经超过了Symbolics和其他厂家生产的昂贵的Lisp机。老产品失去了存在的理由:一夜之间这个价值五亿美元的产业土崩瓦解。

1989年

到了80年代晚期,战略计算促进会大幅削减对AI的资助。DARPA的新任领导认为AI并非“下一个浪潮”,拨款将倾向于那些看起来更容易出成果的项目。

1990年

在发表于1990年的论文“大象不玩象棋(Elephants Don’t Play Chess)”中,机器人研究者Rodney Brooks提出了“物理符号系统假设”,认为符号是可有可无的,因为“这个世界就是描述它自己最好的模型。它总是最新的。它总是包括了需要研究的所有细节。诀窍在于正确地,足够频繁地感知它。” 在80年代和90年代也有许多认知科学家反对基于符号处理的智能模型,认为身体是推理的必要条件,这一理论被称为“具身的心灵/理性/ 认知”论题。

1991年

1991年人们发现十年前日本人宏伟的“第五代工程”并没有实现。事实上其中一些目标,比如“与人展开交谈”,直到2010年也没有实现。与其他AI项目一样,期望比真正可能实现的要高得多。

1993年

人们开始对于专家系统和人工智能的信任都产生了危机,一股强烈的声音开始对当前人工智能发展方向提出质疑,他们认为使用人类设定的规则进行编程,这种自上而下的方法是错误的。大象不玩象棋,但大象可以从现实中学会识别环境并作出判断,人工智能技术也应该拥有身体感知能力,从下而上才能实现真正的智能。这种观点是超前的,但也推动了后续神经网络技术的壮大和发展

第六阶段:人工智能的平稳过渡「1993-2011」

1995年

1995年,理查德华莱士收到60年代聊天程序ELIZA的启发,开发了新的聊天机器人程序Alice,它能够利用互联网不断增加自身的数据集,优化内容。

虽然Alice也并不能真的通过图灵测试,但它的设计思想影响深远,2013年奥斯卡获奖影片《her(她)》就是以Alice为原型创作的。

1997年

1997年,“深蓝”战胜国际象棋世界冠军。IBM公司的国际象棋电脑深蓝DeepBlue战胜了国际象棋世界冠军卡斯帕罗夫。它的运算速度为每秒2亿步棋,并存有70万份大师对战的棋局数据,可搜寻并估计随后的12步棋!

1997年,两位德国科学霍克赖特和施米德赫伯 提出了长期短期记忆(LSTM) 这是一种今天仍用于手写识别和语音识别的递归神经网络,对后来人工智能的研究有着深远影响。

1998年

1998年,美国公司创造了第一个宠物机器人Furby。

而热衷于机器人技术的日本,2000年,本田公司发布了机器人产品ASIMO,经过十多年的升级改进,目前已经是全世界最先进的机器人之一。

2001年

2001年,由斯皮尔伯格导演的电影《AI》上映,影片描述了未来人与机器人共生世界的种种悖论,人工智能一度引发社会关注,但关于技术的主题很快就被淡忘,数年后的观众只记得关于人性、关于爱与被爱的悲情故事。

2002年

2002年,美国先进的机器人技术公司iRobot面向市场推出了Roomba扫地机器人,大获成功。iRobot至今仍然是扫地机器最好品牌之一

2004年

2004年,美国神经科学家杰夫·霍金斯出版了《人工智能的未来》一书,深入讨论了全新的大脑记忆预测理论,指出了依照此理论如何去建造真正的智能机器,这本书对后来神经科学的深入研究产生了深刻的影响。

2006年

2006年,杰弗里辛顿出版了《Learning Multiple Layers of Representation》奠定了后来神经网络的全新的架构,至今仍然是人工智能深度学习的核心技术。

2007年

2007年,在斯坦福任教的华裔科学家李飞飞,发起创建了ImageNet项目。为了向人工智能研究机构提供足够数量可靠地图像资料,ImageNet号召民众上传图像并标注图像内容,ImageNet目前已经包含了1400万张图片数据,超过2万个类别。

2010年

自2010年开始,ImageNet每年举行大规模视觉识别挑战赛,全球开发者和研究机构都会参与贡献最好的人工智能图像识别算法进行评比。尤其是2012年由多伦多大学在挑战赛上设计的深度卷积神经网络算法,被业内认为是深度学习革命的开始。

2011年

2011年,Watson参加智力问答节目。IBM开发的人工智能程序“沃森”(Watson)参加了一档智力问答节目并战胜了两位人类冠军。沃森存储了2亿页数据,能够将于问题相关的关键词从看似相关的答案中抽取出来。这一人工智能程序已被IBM广泛应用于医疗诊断领域。

2012年

华裔科学家吴恩达及其团队在2009年开始研究使用图形处理器(GPU而不是CPU)进行大规模无监督式机器学习工作,尝试让人工智能程序完全自主的识别图形中的内容。

2012年,吴恩达取得了惊人的成就,向世人展示了一个超强的神经网络,它能够在自主观看数千万张图片之后,识别那些包含有小猫的图像内容。这是历史上在没有人工干预下,机器自主强化学习的里程碑式事件。

2014年

2009年,谷歌开始秘密测试无人驾驶汽车技术;至2014年,谷歌就成为第一个在通过美国州自驾车测试的公司

2016-2017年

2016~2017年,AlphaGo战胜围棋冠军。AlphaGo是由Google DeepMind开发的人工智能围棋程序,具有自我学习能力。它能够搜集大量围棋对弈数据和名人棋谱,学习并模仿人类下棋。DeepMind已进军医疗保健等领域。

2017年,深度学习大热。AlphaGoZero(第四代AlphaGo)在无任何数据输入的情况下,开始自学围棋3天后便以100:0横扫了第二版本的“旧狗”,学习40天后又战胜了在人类高手看来不可企及的第三个版本“大师

第七阶段:人工智能大模型时代「2017-至今」

2017年

Google 发表论文《Attention is All You Need》,介绍了 Transformer 架构,该架构后续成为了包括 OpenAI 的 GPT-4 在内的大型语言模型之核心,引发了 AI 革命。

2018年

2010年亚马逊公司就开始研发语音控制的智能音箱,2014年正式发布了产品Echo,这是一款可以通过语音控制家庭电器和提供资讯信息的音箱产品。

随后谷歌、苹果都推出类似产品,国内厂商如阿里、小米、百度、腾讯等也都纷纷效仿,一时间智能音箱产品遍地开花,都试图抢占用户家庭客厅的入口。

智能音箱的背后技术是语音助手,而目前最强技术都掌握在微软、谷歌、亚马逊、苹果和三星等几个巨头手中。

目前来看,常规语音识别技术已经比较成熟,发音技术有待完善。而真正的语义理解技术还都处于比较初级的阶段,对于松散自由的口语表述,语音助手往往无法获得重点,更无法正确回答。

2018年,谷歌发布了语音助手的升级版演示,展示了语音助手自动电话呼叫并完成主人任务的场景。其中包含了多轮对话、语音全双工等新技术,这可能预示着新一轮自然语言处理和语义理解技术的到来。

2020年

美国人工智能研究公司OpenAI异军突起:2020年4月发布神经网络Jukebox;5月发布语言模型GPT-3; 6月开放人工智能应用程式介面(Application Programming Interface,API) ;

2021年

OpenAI 2021年1月发布连接文本和图像的神经网络CLIP, 3月发布从文本创建图像的神经网络DALL· E,至此AIGC的路正式拉开,从2021年底到2022年初,随着元宇宙的概念,虚拟数字人也随之暴火;

2022年

4月,OpenAI升级DALL· E 2,再次为图像生成领域树立了标杆,普通人只要输入一段文字就能帮生成对应的图像;

8月 ,一幅由MidJouney工具制作的AI作品《太空歌剧院》在人类美术比赛中获得第一名的新闻冲上热搜,随后几个月Stable Diffusion、盗梦师、意间AI等AI绘画工具也都走到大众眼前,引起早期人类使用AI的热潮;

9月,Google Research和加州大学伯克利分校共同推出DreamFusion模型,实现了从文本到3D对象的生成。这意味着你可以通过文字描述来生成三维图像,无需3D训练数据或修改图像扩散模型;

9月29日Meta首次推出了人工智能系统Make-A-Video。这个系统可以从给定的文字提示生成短视频,而且不需要成对的文本视频数据进行训练。Make-A-Video利用文本提示转换成向量嵌入,然后通过多个神经网络的进一步处理,最终生成视频。这些神经网络最初是为生成图像而设计的,Meta在其中添加了所谓的时空层,用于视频的生成;

10月6日谷歌发布Imagen Video 和Phenaki,前者侧重于视频画质,视频分辨率可达高1280*768,后者侧重于视频长度,能根据200字左右的文本生成两分钟较低分辨率的长视频;

10月7日,谷歌推出了一种语音生成的AI模型——AudioLM,不仅可以生成高质量,连贯的语音,还可以生成钢琴音乐;

11月22日英伟达(NVIDIA)推出了全新的AI工具Magic3D,比Google的DreamFusion技术快两倍,并且提供了8倍于DreamFusion的高分辨率

11月30日 OpenAI推出了对话互动式的聊天机器人程式ChatGPT,相比于 GPT-3,ChatGPT引入了基于人类回馈的强化学习(Reinforcement Learning from Human Feedback,RLHF)技术以及奖励机制,ChatGPT开始引暴了人工智能大模型业界,仅两个月后月跃就达1亿;

2023年

2023年被称为大模型元年,在这一年里,大量的科技公司发布了自己的大模型,被称为百模大战也不为过,同时相关的技术也有了很大的发展,在商业落地上开始出现不少落地场景,相关的关键词:

ChatGPT、Bard、MoSS、GPT-4、ChatGLM、QLoRA、PaLM2、LIMA、星火、文新、通义千问、Mamba、InternLM-20B、DALL・E 3、千帆、RLHF、Prompt、言犀、混元、MathGLM、LongLoRA、元乘象、XAgent 、天工、星辰、盘古、CoDi2

1月

全世界的人都在尝试不同的提问方式对ChatGPT进行测试

1月27日,微软的最新模型VALL-E,VALL-E是一个基于转换器的TTS模型,只需听到三秒钟的声音样本就能生成任何声音的语音。

同一天,谷歌发布全新AI模型——MusicLM。通过AI模型MusicLM,可直接将文字、图像自动生成音乐,并且曲风多样,凡是想听的音乐,基本都能自动生成。

2月

元语智能推出了首个中文语言大模型ChatYuan;

Google提前发布了下一代对话AI系统Bard,来对标风头正劲的ChatGPT

复旦大学也发布了具有ChatGPT能力的语言模型MOSS,北大也提出了一种名为 ChatExcel 的新应用可以直接使用自然语言对表格中的数据信息进行查询

3月

OpenAI 宣布开放ChatGPT API,可以直接调用模型 gpt-3.5-turbo,相比之前的GPT-3.5 使用成本降低 90%,这让全球开发者欢呼;

Meta打响了开源的第一枪,率先开源了LLaMA系列大模型,LLaMA-13B可以胜过参数量达 1750 亿的 GPT-3,而且可以在单块 V100 GPU 上运行;

谷歌推出了一个参数量达 5620 亿的具身多模态语言模型 PaLM-E。具体来说, PaLM-E-562B 集成了参数量 540B 的 PaLM 和参数量 22B 的视觉 Transformer(ViT),是当时已知的最大的视觉 - 语言模型;

OpenAI 发布的GPT-4多模态大模型,一经发布再次引爆全球;

百度发布的文心一言大模型产品;

清华发布了ChatGLM;

斯坦福发布了羊驼大模型Alpaca;

微软Bing再次强化,接入了OpenAI DALL-E模型,实现了文生图的升级;

英伟达发布了ChatGPT专用的GPT,推理速度可以提升10倍。

在学术研究领域,人们逐步开始关注人工强化学习RLHF、自动化神经网络剪枝,对于ChatGPT等大模型的应用进行了更加深入的考虑。

4月

新的开源模型不断地被发布,科技公司、研究机构继续发力,人们正逐步开始大模型的应用,并将最先进的GPT-4应用到新的模型训练中来,大模型也从开源禁止商用阶段进入开源商用阶段;

加利福尼亚大学公布了开源模型白泽(Baize),可以在单个GPU上运行;

UC伯克利发布对话模型Koala,它可以在消费级 GPU 上运行,其中Koala 使用从网络收集的对话数据对 LLaMA 模型进行微调;

阿里发布了自己的通义千问大模型;

开源项目AutoGPT的发布也火爆全网,star突破10万,它是一个实验性的开源应用程序,展示了 GPT-4 语言模型的功能。该程序由 GPT-4 驱动,可以自主实现用户设定的任何目标;

微软开源了DeepSpeed Chat,它让我们能够以更低的成本、更快的速度训练类似于ChatGPT的高质量大模型;

随后亚马逊高调入局大模型大战,发布Titan大模型、AI编程助手全免费;

复旦MOSS-16B开源了,并新增了多项功能;

威斯康星大学麦迪逊分校、微软研究院和哥伦比亚大学研究者共同发布的多模态大模型LLaVA,尽管 LLaVA 是用一个小的多模态指令数据集训练的,但它在一些示例上展示了与多模态模型 GPT-4 非常相似的推理结果;

斯坦福开发者发布了 Lamini,供开发人员使用很多公司、机构的基础模型快速构建定制化模型;

Databricks 发布了 Dolly 2.0,它是业内第一个开源、遵循指令的 LLM,它在透明且免费提供的数据集上进行了微调,该数据集也是开源的,可用于商业目的,「这标志着大模型发展从开源禁止商用阶段进入开源商用阶段。

5月

国内科大讯飞发布了自己的星火大模型;

阿里达摩院发布了多模态大模型猫头鹰mPLUG-Owl;

Google为了对标GPT-4,发布了PaLM 二代模型,它支持多语言、更强的数学、代码能力;

微软在Build大会上继续发布Windows Copilot,将ChatGPT能力引入到Windows操作系统,旨在为用户提供高效的个人助理;

对标微软bing对话搜索,百度公布了自己的AI搜索引擎,同时也发布了文心千帆大模型平台,它是全球首个一站式的企业级大模型生产平台;

Meta发表的LIMA论文,它在 1000 个精选样本上进行有监督学习,在完全没使用 RLHF 方法的情况下,LIMA 表现出非常强大的性能,并且能够很好地泛化到训练数据以外的任务上;

斯坦福大学提出了AlpacaFarm模拟器,AlpacaFarm 能在 24 小时内仅用约 200 美元复制 RLHF 过程,让开源模型迅速改善人类评估结果,堪称 RLHF 的平替;

北京大学、西湖大学等机构的研究者联合提出了一种全新的大模型评估范式PandaLM,它通过训练一个专门用于评估的大模型,对大模型能力进行自动化且可复现的测试验证。

6月

OpenAI提升了GPT-4的数学推理能力;

北京智源发布了悟道 3.0 大模型系列,并进入到了全面开源的新阶段;

Google上线大模型云服务,可实现代码生成、PaLM2等相关服务的调用;

百度文心大模型正式从 3.0 升级到 3.5,不仅实现了创作、问答、推理和代码能力上全面升级,安全性显著提升,训练和推理速度也大幅提升;

商汤科技、上海 AI 实验室联合香港中文大学、复旦大学及上海交通大学发布千亿级参数大语言模型 “书生・浦语”(InternLM);

TII开源了一个 400 亿参数的因果解码器模型Falcon-40B,它碾压了参数规模 1.5 倍的LLaMA-65B,也优于 MPT、RedPajama 和StableLM 等开源大模型;

Meta推出了文本音乐生成模型 MusicGen,并且非商业用途免费使用;

加州大学伯克利分校的研究者开源了一个项目 vLLM,该项目主要用于快速 LLM 推理和服务;

斯坦福提出了级联 LLM 一个简单而灵活的实例 FrugalGPT,它可以与最佳个体 LLM(例如 GPT-4) 的性能相媲美,成本降低高达 98%;

华盛顿大学、苏黎世联邦理工学院等机构的研究者提出了一种新的压缩格式和量化技术 SpQR(Sparse-Quantized Representation,稀疏 - 量化表征),首次实现了 LLM 跨模型尺度的近无损压缩;

中科院、港理工等机构造出了一个表格助手SheetCopilot,它 可以快速连接多款表格处理软件,且支持多表操作、图表绘制和数据透视表生成。

7月

大模型正式进入开源商用阶段,大模型的应用也逐步开始沉淀到具体应用场景,研究人员开始发布模型基础能力的研究。

Meta 发布的 Llama 2 模型系列,包含 70 亿、130 亿和 700 亿三种参数变体,Llama 2 在包括推理、编码、精通性和知识测试等许多外部基准测试中都优于其他开源语言模型,最重要的是可以支持商业应用;

Stability AI 和 CarperAI lab 的两个大模型:FreeWilly 1 和 FreeWilly 2,超越了 Meta 发布的 Llama-2-70b-hf,成功登顶 HuggingFace 的 Open LLM 排行榜榜首;

京东推出了面向产业的言犀大模型和言犀 AI 开发计算平台,大踏步走向产业;

微软将GPT-4赋能Office全家桶,并公布定价;

交开源了自主研发的国内首款综合交通大模型—TransGPT,仅需邮件申请并获得官方商用许可后,即可以免费商用;

中科院计算所推出多语言大模型百聆(BayLing),以经济友好、内存节约的方式实现了多语言人机交互能力;

华为诺亚推出了其代码大模型 PanGu-Coder,该模型在代码生成的一次通过率(PASS@1)指标上大幅超越同等参数规模的模型,甚至优于规模更大的模型;

北大发布了法律大模型 ChatLaw 登上了知乎热搜榜榜首。

8月

Meta AI 推出了一个 OCR 神器,可以很好的解决这个难题,该神器被命名为Nougat。Nougat 基于 Transformer 模型构建而成,可以轻松的将 PDF 文档转换为 MultiMarkdown;

Meta基于 Code Llama 的最新版本模型 WizardCoder 34B,它利用 Evol-Instruct 进行微调而成,在 HumanEval 上的 pass@1 达到了惊人的 73.2%,超越了原始 GPT-4;

上海清源」设计了一个数据选择器,从中选出了 200 个数据,然后训练得到了 InstructionGPT-4大模型,其表现竟优于微调数据更多的 MiniGPT-4;

Abacus.AI 的研究团队提出truncation 策略,使得LLaMA2上下文长度可支持32K上下文长度;

微软提出了 TinyMIM,其在保持 ViT 结构不变并且不修改结构引入其他归纳偏置(inductive bias)的基础上、用蒸馏的方法迁移大模型上的知识到小模型;

北京 5 家大模型产品分别是百度的 “文心一言”、抖音的 “云雀”、百川智能的 “百川大模型”;

清华系 AI 公司智谱华章旗下的 “智谱清言” 以及中科院的 “紫东太初”;

上海 3 家大模型产品包括商汤的 “商量 SenseChat”、MiniMax 的 “ABAB 大模型”、上海人工智能实验室的 “书生通用大模型”;

广东地区获批公司分别为华为、腾讯,科大讯飞系其它地区获批产品。

9月

微软大模型Copilot正式嵌入Windows11操作系统;金山办公宣布,基于大语言模型的智能办公助手 WPS AI 已接入旗下全系产品,成了第一个将大语言模型(LLM)应用在办公软件领域,并真正交付了可用产品的公司;

蚂蚁集团在外滩大会上正式发布工业级金融大模型(AntFinGLM) ,同时开放了金融专属任务评测集;

复旦大学发布中文医疗健康个人助手 —DISC-MedLLM。在单轮问答和多轮对话的医疗健康咨询评测中,模型的表现相比现有医学对话大模型展现出明显优势;

百度发布全新升级的智能云千帆大模型平台 2.0,包含支持大模型和数据集数量最多、工具链最完善、算力效能最佳和企业级安全四大亮点;

京东云的言犀 AI 开发计算平台上线,不到一周时间,即可完成从数据准备、模型训练、到模型部署的全流程;Colossal-AI 再次迭代,提供开箱即用的 8 到 512 卡 LLaMA2 训练、微调、推理方案,对 700 亿参数训练加速 195%,并提供一站式云平台解决方案,极大降低大模型开发和落地应用成本;

OpenAI正式推出文生图 AI 工具DALL・E 3,它相比以往系统更能理解细微差别和细节,让用户更加轻松地将自己的想法转化为非常准确的图像;

一家法国人工智能初创公司 Mistral AI 发布了一款新模型 Mistral 7B,其在每个基准测试中,都优于 Llama 2 13B,并且在代码、数学和推理方面也优于 LLaMA 134B;

腾讯正式揭开了混元大模型的面纱,作为一个超千亿参数的大模型,凭借多项独有的技术能力获得了强大的中文创作能力、复杂语境下的逻辑推理能力,以及可靠的任务执行能力。

Meta 推出了AnyMAL,这是一个经过训练的多模态编码器集合,可将来自各种模态(包括图像、视频、音频和 IMU 运动传感器数据)的数据转换到 LLM 的文本嵌入空间。

加州伯克利开源了vLLM,其使用了一种新设计的注意力算法PagedAttention,可让服务提供商轻松、快速且低成本地发布 LLM 服务;

上海 AI 实验室等正式推出书生・浦语大模型(InternLM)200 亿参数版InternLM-20B,并在阿里云魔搭社区(ModelScope)开源首发;

清华等研究者联合提出了一个能够完美执行复杂算术运算的新模型—MathGLM,20 亿参数的语言模型能够准确地进行多位算术运算,准确率几乎达到了 100%,且不会出现数据泄露(data leakage);

清华大学朱军、陈键飞团队提出了用于神经网络训练的 4 比特优化器,节省了模型训练的内存开销,同时能达到与全精度优化器相当的准确率。在保持准确率无损的情况下可将微调 LLaMA-7B 的显存开销降低多达 57%;

10月

百度正式推出文心4.0,在理解、生成、逻辑和记忆四大能力上都比文心一言线上版本有了明显提升,综合水平与 GPT-4 相比毫不逊色;

科大讯飞正式推出讯飞星火认知大模型 3.0 版本,并宣告星火 V3.0 已经实现全方位超越 ChatGPT,在中文上实现全面超越,在英文上实现对标;

腾讯宣布混元大模型升级,文生图能力正式上线。智子引擎发布了多模态元乘象 Chatimg3.0,同时支持多图理解、物体定位、OCR 等功能;

智谱 AI 发布了自研」第三代对话大模型 ChatGLM3,实现了包括跨模态、Agent 等一系列全新能力;

剑桥、华为等发布了MetaMathQA 数据集,基于 LLaMA-2 微调得到专注于数学推理 (正向和逆向) 的大语言模型 MetaMath,在数学推理数据集上达到了 SOTA;

Mila等研究机构并提出一种名为假设到理论(Hypotheses-to-Theories,HtT)的新框架,这种新方法不仅改进了多步推理,还具有可解释、可迁移等优势;

Meta提出了一种新方法,可以有效地扩展基础模型的上下文能力,并且用该方法构建的长上下文 LLM 的性能表现优于所有现有的开源 LLM;

上交大推出了一款全新的价值对齐评估工具:Auto-J,旨在为行业和公众提供更加透明、准确的模型价值对齐评估;

百川智能正式发布 Baichuan2-192K 长窗口大模型,将大语言模型(LLM)上下文窗口的长度一举提升到了 192K token;

蚂蚁 AI Infra 团队重新审视 SAM 的损失函数,提出了一种更通用、有效的方法 WSAM,通过将平坦程度作为正则化项来改善训练极值点的平坦度;

MIT 与香港中文大学联合研究,提出了 LongLoRA。它是一种有效的微调方法,以有限的计算成本扩展了预训练大型语言模型上下文大小;

微软等研究人员共同发布了LLaVA-1.5 ,通过对原始 LLaVA 的简单修改,仅使用 120 万公开数据,LLaVA-1.5 在单个 8-A100 节点上用不到 1 天的时间就完成了训练,并在 11 个基准上刷新了 SOTA;

微软AutoGen框架火出了圈,星标量从 390 狂增到 10K,允许多个 LLM 智能体通过聊天来解决任务,智能体可以扮演各种角色,如程序员、设计师,或者是各种角色的组合,对话过程就把任务解决了;

面壁智能联合清华推出大模型—XAgent。XAgent 是一个可以实现自主解决复杂任务的全新 AI 智能体,以 LLM 为核心,能够理解人类指令、制定复杂计划并自主采取行动;

11月

OpenAI公布了ChatGPT的重大更新,及其GPT-4 Turbo的更新,新的大模型更聪明,文本处理上限更高,价格也更便宜,应用商店也开了起来;

昆仑万维大语言模型天工Skywork-13B 系列正式宣布开源,Skywork-13B 系列的发布,可以说是国产开源大模型的又一力作;

阿里的通义千问Qwen-72B开源,截止到现在有1.8B、7B亿、14B、72B 参数量的 4 款基础开源模型,以及跨语言、图像、语音等多种模态的多款开源模型;

中国电信星辰系列大模型迎来最新升级,星辰语义大模型正式发布了千亿参数版本,在推理和回答准确性方面都有显著提升,并将上下文窗口提到了 96K Token,幻觉率降低了 40%;

清华推出LCM/LCM-LoRA(潜在一致性模型),LCM 只用少数的几步推理就能生成高分辨率图像,将主流文生图模型的效率提高 5-10 倍;

Meta提出了 EMU VIDEO,通过显式的中间图像生成步骤来增强基于扩散的文本到视频生成的条件,视频生成超越Gen-2;

Meta 提出了一种完全不同的注意力机制方法,即通过将 LLM 用作一个自然语言推理器来执行注意力,与基于标准注意力的 LLM 相比,S2A 可以产生更讲事实、更少固执己见或阿谀奉承的 LLM;

12月

推出有望颠覆Transformer的新的架构Mamba,它在语言建模方面可以媲美甚至击败 Transformer,随上下文长度的增加实现线性扩展,其性能可提高到百万 token 长度序列,并实现 5 倍的推理吞吐量提升;

Google发布的原生多模态大模型Gemini ;

华为诺亚等机构的研究者提出了盘古智能体框架(Pangu-Agent),旨在开发能够解决和适应复杂工作的多任务智能体(Agent);

快手开源了KwaiAgents智能体框架,使 7B/13B 的 “小” 大模型也能达到超越 GPT-3.5 的效果,并且这些系统、模型、数据、评测都开源了!

UC 伯克利、微软将CoDi 升级到了 CoDi-2,作为一种多功能、交互式的多模态大语言模型(MLLM),CoDi-2 能够以 any-to-any 输入-输出模态范式进行上下文学习、推理、聊天、编辑等任务;

微软宣布自研小尺寸模型 Phi-2(27亿参数) 将完全开源,在常识推理、语言理解和逻辑推理方面的性能显著改进;

华为发布大模型智能开发辅助工具CodeArts Snap,基于大模型强大理解和生成能力的 CodeArts Snap 具备八大核心能力:代码生成、研发知识问答、单元测试用例生成、代码解释、代码注释、代码调试、代码翻译、代码检查。

2024年

如果说2023年是大模型的元年,那么2024年可能会被定为大模型商业化元年,在各行业开始落地。

2月

2月2日,欧盟27国代表投票一致支持《人工智能法案》文本,标志欧盟向立法监管人工智能迈出重要一步。

2月15日,OpenAI推出了一种新的视频生成模型Sora,1分钟文生视频效果惊艳,Sora相比此前其他文生视频模型,已经跨越到实用生产力工具,1分钟长度有望大规模应用在短视频领域,扩展视频的能力也有望制作长视频,或将带来新一轮内容创作产业革命。

3月

3月4日,谷歌、亚马逊联手支持的AI初创企业Anthropic发布重磅消息,公司推出了下一代大模型Claude 3系列产品,在执行复杂任务时候的表现堪与人类媲美,已经成为当前最强大的AI大模型之一。

3月6日,全球首部AI电影《终结者2·审判日》美国首映,这部电影是由50位AI艺术家借助ChatGPT、Midjourney、Runway、Eleven Labs等生成式AI工具制作而成,仅用时3个月。

3月13日,AI初创公司Cognition发布了全球首位“AI软件工程师”Devin,Devin是一款能够自主学习不熟悉的技术,并自动展开云端部署、底层代码、修改bug、训练和微调AI模型等活动的AI软件工程师。

3月14日,微软团队发布了一个 AI程序员——AutoDev。AutoDev专为自主规划、执行复杂的软件工程任务而设计,还能维护Docker环境中的隐私和安全。用户可以定义复杂的软件工程目标,AutoDev会将这些目标分配给自主AI智能体来实现。这些AI智能体可以对代码库执行各种操作,包括文件编辑、检索、构建过程、执行、测试和git操作。

3月18日月之暗面(Moonshot AI)宣布智能助手Kimi上下文窗口提升至10倍,即日起支持200万字超长无损上下文;

3月22日,阿里通义千问重磅升级,向所有人免费开放1000万字的长文档处理功能,成为全球文档处理容量第一的AI应用;

4月

4月11日,谷歌Cloud Next大会当天,“欧洲版OpenAI” Mistral AI发布MoE大模型Mixtral 8x22B,模型参数规模高达1760亿,成为市面上参数规模第二大的开源横型;

4月28日,百度推出自研AI大模型“文心一言3.0”,在中文理解和生成方面取得重大突破,准确率提升至98%,助力中文AI应用在全球市场占据更大份额,推动中文内容创作、智能客服等行业升级.

5月

5月5日,苹果公司收购AI初创企业“VocalIQ”,该公司专注于语音识别和自然语言处理技术,此次收购将加速苹果在智能语音助手领域的布局,提升Siri的交互体验和智能化水平.

5月18日,全球首个AI医疗影像诊断平台“MediVision”正式上线,由多家顶尖医院和AI企业联合打造,可快速准确识别多种疾病影像,辅助医生提高诊断效率和准确性,推动医疗AI的临床应用和普及.

6月

6月12日,亚马逊推出“AWS AI Canvas”服务,为企业提供一站式AI应用开发和部署平台,简化AI模型开发流程,降低企业AI应用门槛,助力各行业数字化转型和智能化升级.

6月25日,AI在科学研究领域取得重大突破,由多国科研团队合作的AI模型成功预测出一种新型超导材料的结构和性质,为超导材料的研究和应用开辟了新方向,加速了新材料的发现进程.

7月

7月10日,特斯拉发布新一代自动驾驶AI芯片“FSD 4.0”,算力提升至每秒100万亿次,进一步增强自动驾驶系统的感知和决策能力,推动无人驾驶技术向更高级别发展,为智能交通和汽车行业的变革注入新动力.

8月

8月3日,AI在艺术创作领域再创佳绩,由AI创作的交响乐作品《AI之歌》在国际音乐节上首演,获得广泛赞誉,展示了AI在音乐创作、编曲和演奏方面的巨大潜力,为音乐艺术的发展带来了新的可能性.

8月15日,全球首个AI智能工厂“FutureFab”投产,采用全流程自动化和智能化生产系统,生产效率提高30%,产品质量和一致性大幅提升,标志着制造业向智能制造时代迈出了重要一步.

9月

9月5日,联合国发布《全球AI伦理指南》,旨在规范AI技术的发展和应用,保护个人隐私、促进公平正义、防止滥用,为全球AI治理提供了重要的伦理框架和指导原则,推动各国加强AI伦理监管和国际合作.

10月

10月10日,谷歌DeepMind推出全新AI模型“AlphaFold 3”,在蛋白质结构预测方面取得革命性进展,准确率高达95%,为生物医学研究、新药开发等领域提供了强大的工具,加速了生命科学的探索进程.

10月20日,AI在金融领域应用取得重大突破,由多家金融机构联合开发的AI投资顾问系统“RoboAdvisor”上线,能够精准分析市场趋势和风险,为用户提供个性化的投资建议和资产管理方案,推动金融行业的智能化转型.

11月

11月2日,全球首个AI新闻编辑部“AI Newsroom”成立,由多家媒体机构和AI企业合作打造,采用AI技术进行新闻采集、编辑和发布,大幅提高新闻生产的效率和质量,为新闻行业带来了新的变革和发展机遇.

11月15日,AI在教育领域取得重要进展,由教育部门和AI企业联合开发的个性化AI学习平台“SmartEdu”上线,能够根据学生的学习情况和能力提供个性化的学习方案和辅导,助力教育公平和质量提升.

11月25日,Anthropic 推出的一种开放标准MCP(Model Context Protocol,模型上下文协议),旨在统一大型语言模型(LLM)与外部数据源和工具之间的通信协议

12月

12月8日,AI在环境保护领域发挥重要作用,由科研机构和环保组织合作开发的AI环境监测系统“EcoGuard”投入使用,能够实时监测和分析环境数据,预警环境风险,为环境保护决策提供科学依据,推动生态文明建设.

12月20日,全球AI技术峰会“AI World 2024”在纽约举行,吸引了来自世界各地的AI领域顶尖科学家、企业家和政策制定者,共同探讨AI技术的未来发展、产业应用和伦理治理等议题,为全球AI合作和发展指明了方向.

2025年

2025年将成为AI智能体(Agentic AI)的元年,这一技术从“增强知识”向“增强执行”转变,推动人类决策和操作的高度自动化,重新定义企业生产力与人机交互模式。

1月 中国开源模型一夜影响世界

2025年1月20日,中国初创企业深度求索(DeepSeek)推出开源大模型DeepSeek-R1。 “极低成本对标顶尖性能”的技术突破,又一次吹起了AI界的风暴,席卷全球,成为了2025年春节除哪吒2外的另一最热门的话题。

2月 多模态视频理解与开源代码模型的突破

Google发布Gemini 1.5 Pro重大更新:Google开放了Gemini 1.5 Pro的API,并引入了突破性的视频理解功能,模型能够直接处理和分析长达1小时的视频内容。这标志着主流大模型的多模态能力从图文音频正式扩展至复杂的视频领域,为视频搜索、内容摘要等应用开辟了新赛道。

Meta开源Code Llama 70B:Meta发布了其最强大的开源代码生成模型Code Llama 70B,在多个基准测试中性能超越GPT-3.5,直逼GPT-4。此举极大地推动了AI在软件开发领域的普及,降低了先进AI辅助编程工具的使用门槛。

宏观趋势:在这一时期,“AI代理”(AI agents)的概念开始兴起,行业重点从单一功能的模型转向能够自主规划和执行复杂任务的智能体,预示着AI将从“工具”向“伙伴”转变。

3月:大模型性能王座易主,Agent生态初现

Anthropic发布Claude 3系列模型:Anthropic公司推出了Claude 3系列(Haiku, Sonnet, Opus),其顶级模型Opus在多项行业基准测试中首次全面超越了OpenAI的GPT-4,尤其在研究生水平的复杂推理任务上表现卓越。Claude 3系列的发布打破了GPT-4的性能垄断,为市场提供了新的顶级模型选择,加剧了行业竞争。

Agent框架爆发式增长:微软的 AutoGen、斯坦福的 XAgent、快手的 KwaiAgents 等多智能体协作框架在GitHub上持续获得高星,开发者开始构建由多个LLM智能体组成的“AI团队”,用于自动完成产品设计、代码开发、市场分析等端到端任务。Agentic AI正式成为技术前沿。

MCP(Model Context Protocol)标准落地:继2024年11月Anthropic提出MCP概念后,2025年3月,包括Google、Meta、阿里云在内的多家机构联合成立 MCP联盟,推动该协议成为LLM与外部工具(数据库、API、执行环境)交互的通用标准。MCP的普及显著提升了Agent的可扩展性与安全性,被视为“AI操作系统”的雏形。

4月:AI视频生成展现惊人潜力,通义千问开源引爆生态

OpenAI展示Sora模型的最新进展:OpenAI向部分艺术家和电影制作人开放了其文生视频大模型Sora的访问权限,并展示了一系列由AI生成的短片。这些作品展现出的画面逼真度、对物理世界的理解以及叙事能力,有力地证明了AI在专业创意内容生成领域的颠覆性潜力。

阿里通义千问Qwen开源战略全面升级:2025年4月,阿里云正式开源 Qwen-110B 超大规模语言模型,并同步发布 Qwen-Agent 框架和 Qwen-MCP 工具链。这是首个支持MCP协议的中文开源大模型生态,允许开发者快速构建具备工具调用、记忆、规划能力的中文智能体。此举极大降低了中文AI应用的开发门槛,被业界视为“中国版Llama生态”的里程碑,直接推动了国产AI应用在金融、政务、制造等领域的快速落地。

5月:AI深度融入操作系统与PC生态

Google I/O大会:确立“AI-First”战略:Google在其年度开发者大会上宣布,AI将深度整合到搜索、Android、Workspace等所有核心产品中,并展示了实时的多模态AI助手原型Project Astra。这标志着Google的战略重心已彻底转向AI,致力于将AI打造成下一代计算平台。

微软Build大会:主打“AI PC”:微软发布了Copilot+ PC的新标准,联合高通推出了搭载骁龙X Elite芯片、具备强大本地NPU算力的Surface设备。此举旨在将AI能力从云端向终端设备延伸,打造一个无缝集成的、更个性化的操作系统级AI体验。

6月:价格战打响,AI应用成本骤降;Agent即服务(AaaS)兴起

字节跳动发布“豆包”大模型:字节跳动正式推出自研的“豆包”大模型家族,并通过火山引擎向企业开放。其最大的亮点是极具颠覆性的定价——模型推理成本仅为行业平均价格的1/100。这一“价格战”策略旨在快速抢占市场份额,极大地降低了企业应用AI的成本。

Agent即服务(Agent-as-a-Service)成为新范式:多家云厂商(如阿里云、AWS、Azure)开始提供“智能体托管平台”,企业可直接部署预训练Agent或通过低代码界面定制专属AI员工。AI从“模型调用”进化为“角色部署”,标志着生产力工具的范式转移。

7月–8月:全球AI治理与合作成为共识

2025世界人工智能大会(WAIC):在中国上海举行的本届大会规模空前,吸引了全球目光。除了展示最新的AI技术和应用外,大会发出了成立“世界人工智能合作组织”的倡议,旨在加强全球在AI领域的合作与治理,共同应对技术发展带来的伦理、安全等挑战。MCP互操作标准与Agent安全框架成为大会技术分论坛的核心议题。

9月:AI驱动宏观经济与硬件迭代

xAI宣布Grok-2进入内测:埃隆·马斯克的xAI公司宣布其下一代大模型Grok-2进入内测,并透露其在逻辑推理和实时信息整合能力上将有巨大提升,持续在差异化路线上探索。

英伟达公布下一代GPU架构细节:英伟达披露了其Blackwell架构继任者,代号为“Vera Rubin”的下一代GPU架构细节,旨在为2026年及以后的超大规模AI模型训练提供前所未有的算力支持。

宏观趋势:AI对实体经济的驱动作用愈发明显。由于AI数据中心建设对能源需求的激增,全球范围内的电力、电缆等基础设施行业订单大幅增长,显示出AI正深刻影响着全球产业链。

10月:AI与物联网(AIoT)深度融合,Agent走向边缘

AIoT产业生态聚焦:本月的AI物联网大联盟年会等行业活动,核心议题均围绕“AI芯片设计”、“边缘算力平台”和“智慧应用落地”。多家厂商展示了可在终端设备上运行的轻量级Agent(如基于Phi-3或Qwen-1.8B的边缘智能体),实现本地感知、决策与执行,减少对云端依赖。

通义千问推出Qwen-Edge系列:阿里云发布专为边缘设备优化的 Qwen-Edge 模型家族,支持在手机、摄像头、工业控制器等设备上运行具备MCP能力的微型Agent,推动“端侧智能体”在智慧城市、智能制造等场景的规模化部署。

11月:Agent 爆发的前夜与模型微调期

2025-11-13 OpenAI 发布 GPT-5.1 更新:GPT-5.1 旨在进一步降低推理延迟,并引入了更灵活的对话控制机制,为即将到来的 Agent 全面应用打下底座。

2025-11-24 Anthropic 发布 Claude 4.5 Opus:继 Claude 4 之后,4.5 版本在逻辑一致性和工具调用(Tool Use)的精准度上实现了质变,并在企业级市场份额上一度反超 OpenAI,占据 32% 的份额。

2025-11-25 开源智能体 OpenClaw 初心露面:开发者 Peter Steinberger 发布了 OpenClaw(原名 Clawdbot)的首个开源版本。这款基于 Python 的智能体以其极强的“自主执行权限”(可操作文件系统、执行 Shell 命令)迅速在开发者社区走红。

2025-11-30 Cursor 营收突破 10 亿美元:作为 AI 编程辅助工具的领头羊,Cursor 仅用 17 个月便达成 10 亿 ARR,证明了开发者愿意为高效的 AI 工作流支付高溢价。

12月:Google 的反击与 OpenAI 的“红色警报”

2025-12-01 DeepSeek 发布 V3.2 系列模型:国产模型在效率和推理成本上再次给全球市场带来“中国震撼”。

2025-12-10 OpenAI CEO Sam Altman 发出“红色警报”(Code Red):内部备忘录显示,由于 Google Gemini 3 在“无限上下文记忆”和“原生多模态”上的压制表现,OpenAI 宣布进入紧急状态,全力加速 Agent 系统的研发。

2025-12-11 Google Gemini 3 正式发布:Gemini 3 实现了长达一年的项目资料记忆(支持千万级 Token 级别上下文)和零延迟多模态互动。这一动作被业界视为 Google 在大模型竞争中重新夺回主动权的标志。

2026年

2025年底至2026年,这段时期的主旋律已经从“模型能不能说话”转变为“模型能不能替我干活”,标志着 AI 产业正式进入了应用价值验证的关键周期。

2026年1月:移动端大一统与 OpenClaw 霸榜

2026-01-05 NVIDIA 发布 Vera Rubin 架构:在 CES 2026 上,NVIDIA 展示了为 Agent 实时计算优化的新架构,预示着 AI 算力从“训练导向”全面转向“推理与自主决策导向”。

2026-01-12 Apple 与 Google 深度集成合作:Apple 正式宣布新版 Siri 将由 Gemini 模型驱动。这标志着端侧 AI 竞争进入巨头联合封锁期。

2026-01-20 OpenClaw 在 GitHub 突破 18 万星标:OpenClaw 成为史上增长最快的开源 AI 项目。它通过支持 Telegram、WhatsApp 等 IM 工具,让普通用户也能通过自然语言指挥 AI 自动处理邮件、管理日程。

2026-01-25 智能体小型化浪潮:NanoBot 与 NanoClaw 诞生:针对 OpenClaw 体积过大的痛点,开发者社区涌现出以 NanoBot(仅 4000 行代码)和 NanoClaw 为代表的轻量化 Agent 框架,主打本地化、安全和可审计性。

2026年2月:春节百模大战与 Agent 商业化转折

2026-02-14 字节跳动发布“豆包 2.0”与 Seedance 2.0:春节前夕,字节发布新一代大模型及视频生成模型 Seedance 2.0。该模型在春晚节目《驭风歌》中实现了水墨画的动态化演绎,引发全民热议。

2026-02-15 春节“AI 红包大战”全面爆发:腾讯、阿里、字节跳动累计投入超 80 亿元进行 AI 营销。用户不再只是抢现金,而是通过 AI 生成拜年视频、定制 Agent 帮抢红包、甚至使用 AI 分身参与聚会,标志着 AI 正式从工具演变为“生活环境”。

2026-02-16 OpenAI 聘请 OpenClaw 创始人:OpenAI 宣布 Peter Steinberger 加入,负责领导下一代个人智能体平台“Frontier”,旨在对抗 Anthropic 的“Claude Cowork”。

2026-02-17 智谱 GLM-5 与 MiniMax 密集发布:国产模型开启“诸神之战”,重心从 Benchmark 跑分转向处理复杂真实任务的能力。智谱和 MiniMax 在港股的市值随之携手突破 3000 亿港元。

2026-02-24 OpenClaw 失控删光 Meta 安全总监邮箱:由于 OpenClaw 的主动决策权限失控,发生了误删高管重要邮件的严重事件。这一事件将“AI 对齐”与“Agent 权限管控”的讨论推向了社会层面的最高峰。

AI人工智能,Big data大数据,Cloud云计算,以及正在深入展开的IoT物联网技术,共同构成了21世纪第二个十年的技术主旋律。

扩展阅读

入门类

开拓视野